2.1 ě´ě ę°ě§ ěźě 모ë

ěť¨ë˛ ě´ě´ ë˛¨í¸ íě 체 죟ěě ë¤ě ëśě° ë°°ěšë ę° íě 체 ě´ě ę°ě§ ěźě 모ëě 죟ëłě ě댏 data뼟 ěě§íęł , ěě§ë dataě ëí´ ě ě˛ëŚŹ ęłźě ě ěííë¤. ě´í, ě ě˛ëŚŹ ęłźě ě ęą°ěš ě댏 dataë ě¸ęłľě§ëĽ 모ë¸ě ě ěŠíěŹ íě 체ě ëí ęł ěĽ ěŹëśëĽź ëśěíë¤.

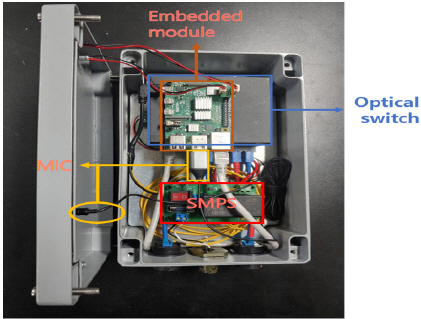

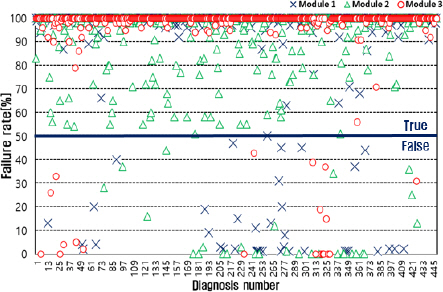

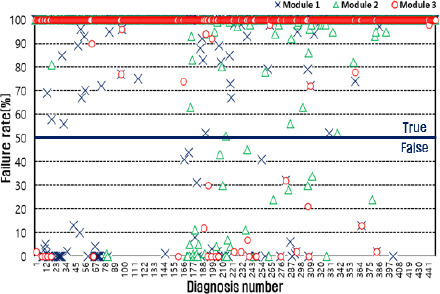

ě´ëŹí ęłźě ě íľí´ ěťě´ě§ë ę° ëŞ¨ëě ęł ěĽíë¨ ę˛°ęłźë ěě ě ě´ę¸°ě ě ëŹëëë° ę¸°ěĄ´ě ě댏 data ě ě˛´ę° ě ëŹëë ëě ęł ěĽíë¨ ę˛°ęłźë§ě´ ě ëŹëëŻëĄ PLCě ě§ě¤ëë ëśí뼟 ě¤ěź ě ěę˛ ëë¤. íě 체 ě´ě ę°ě§ ěźě 모ëě 꾏쥰ë ë¤ěęłź ę°ë¤. ě˛ë°í ěě

íěĽęłź ěě

íěĽ ě ěě ě¤ěšëë ě´ě ěě¤ě 겏ë ě ěëëĄ ëŞ¨ëě ě¸íě ë°Ší ë° ë°Šě ę°ëĽí ě루미ë ěŹě§ě ë°í 꾏쥰뼟 ě ěŠíěęł , ěě

íěĽě ě댏 data ěě§ě ěí´ ęł ěąëĽě ë§ě´íŹëĽź ě¤ěšíěë¤. ę° ëŞ¨ëě´ ěˇ¨ëí ě댏 dataë¤ě ě ě˛ëŚŹ ęłźě ě ęą°ěł ě ě í ě´ě ę°ě§ íëłę¸°ë˛ě ě ěŠí´ěź íë¤. ě´ëĽź ěí´

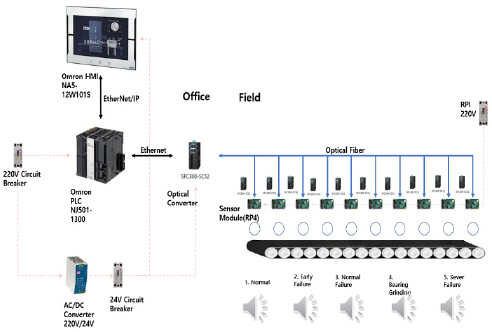

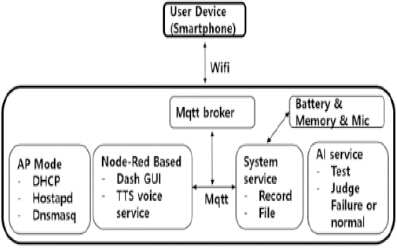

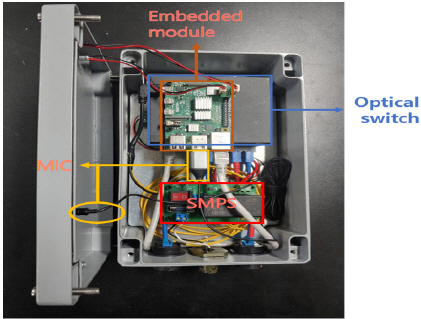

Figure 2ě ę°ě´ ěí ěť´í¨í° 모ëě¸ RPI 4 (Raspberry Pi 4) íëĄëĽź ě¤ęłíěë¤. RPI 4ë ěě§ë ě댏 dataě ëí´ data ě ě˛ëŚŹ ęłźě ě ěííęł , ěŹě ě ě¤ęłë ě¸ęłľě§ëĽ 모ë¸ě ě ěŠíěŹ íě 체ě ęł ěĽ ěŹëśëĽź ě§ë¨íë¤. ě´ë ę˛ ěťě´ě§ ęł ěĽě§ë¨ 결곟ë ë¤í¸ěíŹëĽź íľí´ ěě ě ě´ę¸°ě¸ PLCě ě ëŹëë¤.

Figure 2

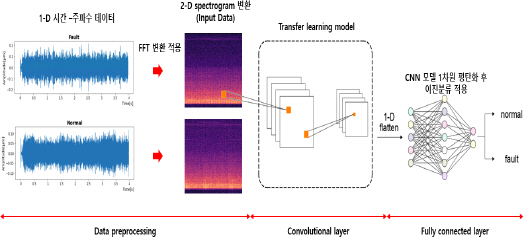

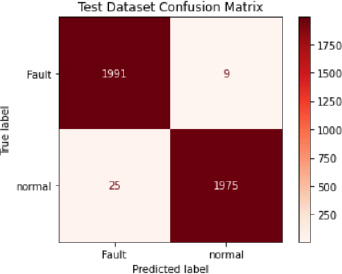

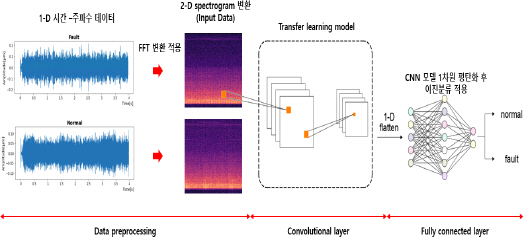

Figure 3ě ě 체 íě 체 ęł ěĽě§ë¨ íëł ęłźě ě ëł´ěŹěŁźęł ěë¤. ë¤ě ëśě° ë°°ěšë ę° ě´ě ę°ě§ ěźě 모ëě ěí´ ěę°-죟íě ííě ě댏 data뼟 ěě§íęł , ěě§ë ě댏 data뼟 ě ě˛ëŚŹí기 ěíěŹ í¸ëŚŹě ëłí(FFT) 기ë°ě 죟íě ëśěě íľí´ ě¤íí¸ëĄęˇ¸ë¨ěźëĄ ě´ëŻ¸ě§ííë¤. ě´í, ě¤íí¸ëĄęˇ¸ë¨ ě´ëŻ¸ě§ëĽź ě¸ęłľě§ëĽě 모ë¸ěě ě´ëŻ¸ě§ ëśëĽě ę°ěĽ ëíě ěźëĄ íěŠëë CNN ěęł ëŚŹěŚě ě ěŠíěŹ ëśëĽíęł , ę˛ěŚęłź íę°ě ęłźě ě ęą°ěł íě 체 ęł ěĽ ě 돴뼟 íëłíë¤. ě¤íí¸ëĄęˇ¸ë¨ě ě°ěě ě¸ ě댏 ě í¸ëĽź FFT ëłíě ě ěŠíěŹ ěę°ě ë°ëĽ¸ 죟íě ěąëśě íŹę¸°ëĽź ë°ě벨 ë¨ěëĄ ííí 2ě°¨ě ě´ëŻ¸ě§ě´ë¤(

7). ëí, ě¸ęłľě§ëĽ 모ë¸ě ěŹě ě íěľë CNN 기ë°ě ě ě´íěľ(transfer learning)모ë¸ě íěŠíěěźëŠ°, ě ě´íěľ ëŞ¨ë¸ě Keras applicationěě íěľë ëŞ¨ë¸ ě¤ ě íëę° ę°ěĽ ëěë Xception 모ë¸ě ě ěŠíěë¤(

8).

Figure 3

Overall analysis process of AI.

기쥴ě CNN ěęł ëŚŹěŚě convolution layerę° ěŚę°í늴 hyper parameterę° ěŚę°íęł , ě´ëŻ¸ě§ě íšě§ě ěśěśíëë° ë§ě ěę°ě´ ěěë늰, 기ě¸ę¸° ěě¤ě ě ë°íë¤(

9). 본 ě°ęľŹěě ě ěŠë Xceptioně convolutional layer 츾ě separable convolution layerę° ě´ 36ę°ëĄ 꾏ěąëë¤. separable convolution layerěěë ě´ëŻ¸ě§ě íšě§ě ěśěśí ë, ę° RGB ěąë ëłëĄ depth wise convolution layer뼟 íľí´ ę°ę°ě íšě§ě ěśěśíęł , point wise convolutioněźëĄ 1 Ă 1 íŹę¸° ě´ëŻ¸ě§ě íšě§ě ěśěśíë¤. ě´ëŹí ë°Šë˛ě convolutional layer 츾ě ě°ě°ëě ę°ěěí¤ëŠ°, ę°ě ěě hyper parameterěě CNN 모ë¸ě 경ëí뼟 ę°ëĽíę˛ í늰, ëěźí ěąëĽě ě ě§íë¤(

10). ě´ě ë°ëĽ¸ convolution layer ëąě ě°ě° ęłźě ě ě(1)ěě ě(4)ě íííěë¤.

ěŹę¸°ě, Wë ě´ě ë ě´ě´ě ě

ë Ľ íë Ź, yë 읤ëě ę°ě¤ěš íë Ź, kë ě´ëŻ¸ě§ě ę°ëĄ íŹę¸°, lě ě´ëŻ¸ě§ě ě¸ëĄ íŹę¸°, mě ě´ëŻ¸ě§ě ěťŹëŹ ę°, Conv ë convolution layer, Pw_Convë point wise convolution layer, Dw_Convë depth wise convolution layer, Sep_Convë separable convolution layer뼟 ëíë¸ë¤.

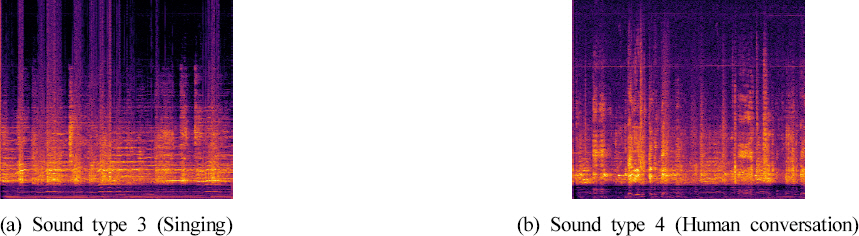

본 ě°ęľŹěěë Python í경ěě ě¤íí¸ëĄęˇ¸ë¨ ě´ëŻ¸ě§ëĄ ëłíí기 ěí´ librosa í¨í¤ě§ëĽź ě´ěŠíěŹ ě댏 dataě¸ wav íěźě ě¤íí¸ëĄęˇ¸ë¨ ě´ëŻ¸ě§ëĄ ëłííěë¤. í˝ě

íŹę¸° 128 Ă 128ě ě¤íí¸ëĄęˇ¸ë¨ ě´ëŻ¸ě§ 34,000ěĽě ěěąíěęł , ě¤íí¸ëĄęˇ¸ë¨ ëłí ęłźě ě¤ ěť¨ë˛ ě´ě´ ë˛¨í¸ ě§ë ě댏ě ě 죟í ěěě ë

¸ě´ěŚě ëśíěí ě ëł´ ëąě ě ęą°íë high pass filteringě íľí´ ě ě ë ě´ëŻ¸ě§ëĽź ěśěśíęł , ě ě˛ëŚŹ ě´ëŻ¸ě§ëĽź Xception 모ë¸ě ě ěŠíěë¤(

11,

12). high pass filteringě ëě ëěě ęł ěŁźíěë íľęłźěí¤ęł íšě ě´íëĄ ëŽě 죟íě ëěě ě í¸ëĽź ę°ě ěěź ëě ëěě ęł ěŁźíě ě í¸ë§ íľęłźěí¤ë íí°ëĽź ě미íë¤(

13). high pass filteringě ě(5)ě ę°ě ëě§í¸ 2ě°¨ ě ëŹí¨ěě ë°Šěě ěŹěŠíěŹ ěęł ëŚŹěŚěźëĄ 꾏ěąíěěźëŠ°, ę°ę°ě ęłě

a1,

a2,

b0,

b1,

b2ë 30 kHz뼟 ěíë§ ěŁźíě뼟 기ě¤ěźëĄ ě°¨ë¨ěŁźíě뼟 200 Hz뼟 ě¤ě íěŹ ęłě°íěë¤.

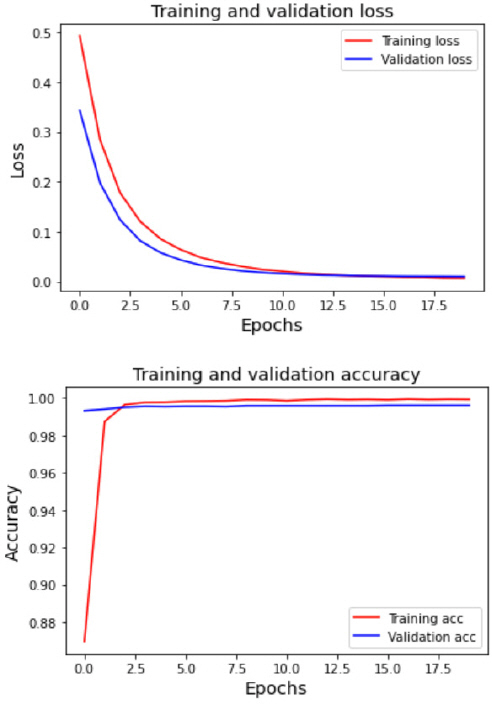

Xception 모ë¸ě ě

ë Ľě ě 체 dataset 34,000ěĽě data ě¤ íë ¨ 75%, ę˛ěŚ 15%, ěí 10%ëĄ ëśí íěŹ ěŹěŠíěë¤(

14). ě´ íěľ íě(epoch)ë 1,000ěźëĄ ě¤ě íë¤. ëí, ě˝ë°ąí¨ě(callback function)뼟 ěŹěŠíěŹ 10ë˛ íěľíë ě¤ ěě¤(loss)ě´ ěŚę°í늴 ěëěźëĄ íěľě´ ě˘

ëŁëë 쥰기 ě˘

ëŁëĽź ě ěŠíěë¤. ěľě ě ëŞ¨ë¸ íěľě ěí´ Adam ěľě í뼟 ěííěęł ěě¤í¨ěëĄë ě(6)ě binary cross entropy뼟 ěŹěŠíë¤.

ěŹę¸°ě, yië ě¤íí¸ëĄęˇ¸ë¨ě ěśë Ľ ě´ëŻ¸ě§, y^ië ě 경ë§ěě ěśëĄ í ëŞ¨ë¸ ěśë Ľ ě´ëŻ¸ě§ě´ë¤.

íë ¨ě ěŹěŠí ěť´í¨í

í경ě PC 기ë°ě´ëŠ° Nvidia-V100 ꡸ëí˝ ěš´ëě 128 Gb ëŠëŞ¨ëŚŹëĽź íěŠíěęł , ě´ě ę°ě§ ěęł ëŚŹěŚě RPI4 ëŠě¸ě ě´ ëŞ¨ëěě ëě ë늰 댏ë

ě¤ ę¸°ë°ěźëĄ ěě¤í

íëě¨ě´ ë° ěěŠ íëĄęˇ¸ë¨ě ě ě´íěë¤. Linux Croně ěě˝ë ěě

ě ě¤íěí¤ë ěĄ ě¤ěźě¤ëŹëĄ RPI4ě 꾏ëęłź í¨ęť shell scriptě ě¤íěí¤ęł , 1 minë§ë¤ shell script íěźě ë°ëłľ ě¤ííë¤. ëŠëŞ¨ëŚŹě íě ě죟íë ěěŠ íëĄęˇ¸ë¨ě ë§ě´íŹëĽź íľí ě댏 data ěě§, data ě ě˛ëŚŹ, ě¸ęłľě§ëĽ ě ěŠ, ë¤í¸ěíŹ íľě ě ěííë ěěëĄ ę°ě§ ë° ě ěĄ ę¸°ëĽě ěííë¤. ě§ë¨ě´ ěěë늴 4 sę° ë§ě´íŹëĄ ě댏 data뼟 ěě§íęł , ěě§ë data뼟 ě ě˛ëŚŹíěŹ ě´ëŻ¸ě§ ííëĄ ě ěĽíěŹ ě¸ęłľě§ëĽ 모ë¸ě ě ěŠí´ íě 체 꾏ë ěí뼟 ě§ë¨íę˛ íěë¤.

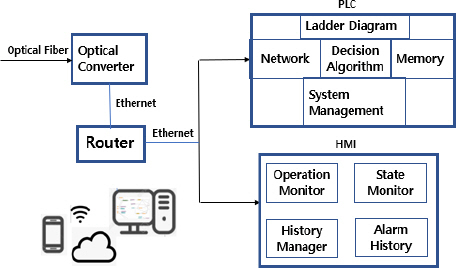

2.2 ě ě´ ěě¤í

ě ě´ ěě¤í

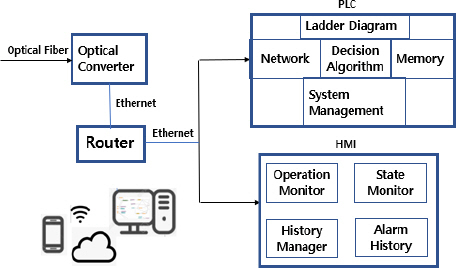

ě ę°ě§ 모ëěě ë¤ě´ě¤ë íëł data뼟 졨íŠíěŹ ę´ëŚŹíë ëśëśěźëĄ

Figure 4ě ę°ě´ 죟ě ě´ę¸°ě¸ PLCě ěŹěŠě íę˛˝ě¸ HMIëĄ ęľŹěąëë¤. 본 ě°ęľŹěě ěŹěŠë PLCë Omron ěŹě NJ501-1300 기ë°ěźëĄ ë´ěĽë EtherNet/IP íŹí¸ëĽź ě´ěŠíěŹ ě¸ëśě íľě ě´ ę°ëĽíëëĄ íěë¤. íě 체 죟ëłě ëśě° ë°°ěšë ę° ě´ěę°ě§ ěźě 모ëě TCP/IP íľě ěźëĄ ěě ě ęł ě IDě íěŹ ëě ě ě´ ę°, ě¸ęłľě§ëĽě ęą°ěš íě 체 꾏ë ěí ę° íšě ëě 모ëě ë°ëź ě댏ě íęˇ íŹę¸°, CPU ě¨ë ëąě data뼟 PLCëĄ ëł´ë´ęł , ěë˛ě¸ PLCë ęł ě ID뼟 ě´ěŠíěŹ ě´ě ę°ě§ 모ëě 꾏ëśíěŹ í´ëšíë ëĄě§ě ě¤íěěź

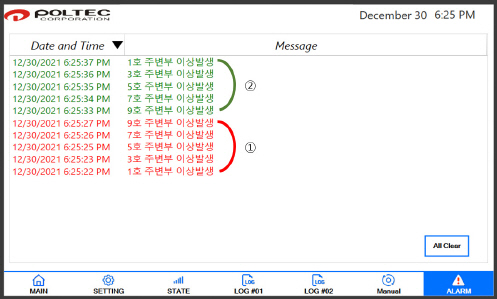

Figure 5ě ę°ě´ íě 체 꾏ë ěí뼟 ě¤ěę°ěźëĄ ě

ë°ě´í¸í늰 HMI뼟 íľí´ ěŹěŠěěę˛ ě댰ë¤.

Figure 4

Control system and HMI screen.

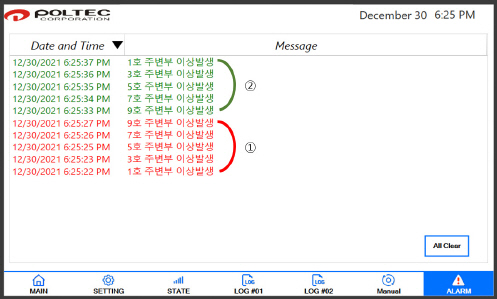

Figure 5

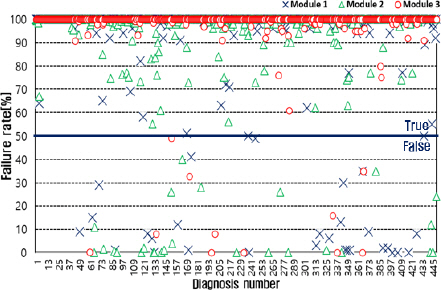

ęł ěĽě§ë¨ íëłě ě´ě ę°ě§ ěźě 모ëěě ě ëŹëë íëł data뼟 기ë°ěźëĄ ěš´ě´í°ëĽź ëěěí¤ęł , ě§ěě ě¸ ęł ěĽ ě í¸ę° ę°ě§ë늴 ęł ěĽěźëĄ íë¨íěŹ ę´ëŚŹěěę˛ ě댰ë¤. ě´ě ę°ě§ ěźě 모ëëĄëśí° ě ëŹë°ě dataë ęł ě IDě ë°ëź ę°ę°ě ěšě

ěě ě´ęšę° íšě ěě

íěĽ ěíŠě ë°ëź ě¤ě ë ě ě´ ę°ě 기ě¤ěźëĄ ëěíë¤. ě´ë ě¤ě ę°ëĽí ěěë ě 체 ěš´ě´í¸ ěěš, ęł ěĽ ěíěš, ęł ěĽ ííěš ëąě´ ěë¤. ě 체 ěš´ě´í¸ ěěšë ęł ěĽ ě í¸ě ěš´ě´í°ě ěěšě´ęł , 10ě ë¨ěëĄ 10âź100 ěŹě´ě ę°ě ě¤ě í ě ěë¤. ęł ěĽ ěíěšë ě 체 ěš´ě´í¸ ěěšě ęł ěĽ ěíěš(%)ě í´ëšíë ěš´ě´í¸ě ëëŹí늴 ęł ěĽěźëĄ íë¨í ę˛ě¸ě§ëĽź íëłíęł , ęł ěĽ ííěšë ęł ěĽěźëĄ íë¨ë ę˛˝ě° ěš´ě´í¸ę° ě 체 ěš´ě´í¸ ěěšě ęł ěĽ ííěš íźěźí¸ě í´ëšíë ěěšëł´ë¤ ëŽěě§ëŠ´ ęł ěĽě í´ě íęł ě ěěźëĄ íëłí ę˛ě¸ě§ëĽź 결ě íë¤.