1. ě ëĄ â

ěľęˇź ě°ě

ě ęľŹěĄ°ę° ëě§í¸ ę¸°ë° ę˛˝ě ě¤ěŹěźëĄ ëłę˛˝ë늰 기쥴ě ěë ëĄęˇ¸ ë°Šěě ě°ě

ě ě ě°¨ ěŹëźě§ęł ěë¤. ě´ëŹí ëłíë ě 쥰ě

ęłź ěëšě¤ě

ě ěľíŠěźëĄ ě´ě´ě§ëŠ° ëěą ě¤ë§í¸íí ěëšě¤ëĽź ě ęłľí기 ěí´ ęłěí´ě ë°ě íęł ěë¤. ě°ě

꾏쥰ě ëě§í¸íě ë°ëź ęą´ě¤ě°ě

ěěë ě¤ë§í¸ ę¸°ë° ę¸°ě ě íěŠíęł ěë ěśě¸ě´ë¤. ě¤ë§í¸ 기ě ě 돴ě¸í ë° ěëí ěě¤í

꾏ěśě 기ë°ě´ ëě´ ëš ëĽ´ę˛ ë°ě íěŹ ě ęˇ ęą´ěśëŹźě ęą´ě¤ ěŚę°ëĄ ě´ě´ě§ë¤(

1).

ęą´ěśëŹźě íěŹě ěŹëâ

ěŹí´, ꡸ ë°ě ěę¸í ěíŠěźëĄëśí° ëł´í¸í기 ěí´ ë˛ëĽ ě 18661í¸ ď˝˘ěë°Šěě¤ ě¤ěš ë° ę´ëŚŹě ę´í ë˛ëĽ 」ě ë°ëź ěë°Šěě¤ëŹźě ě¤ěšíęł ę´ëŚŹí´ěź í ěëŹ´ę° ěë¤. ě ęˇ ęą´ěśëŹźě ěŚę°ë ěë°Šěě¤ëŹź ě¤ěšě ę´ëŚŹí´ěź í ěě¤ëŹźě ěŚę°ëĄ ě´ě´ě§ë¤. ěë°Šě ę˛ě ěë°Šěě ę´ëŚŹě ë° ëł´ěĄ° 기ě ě¸ë Ľ 2ëŞ

ě´ ěíí늰 í루 ëě ě ę˛í ě ěë 늴ě ě 10,000 m

2~12,000 m

2ëĄ ě íëě´ ěë¤. ę´ëŚŹí´ěź í ěë°Šěě¤ě ěŚę°ě ë°ëź ěë°Šěě¤ę´ëŚŹěŹě ěą

ě ëěě ěŚę°íęł ěě§ë§, ě ę˛ě ěíí ě¸ë Ľě ꡸ě ëší´ ëśěĄąí íě¤ě´ë¤(

2). ě´ë ěë°Šěě¤ę´ëŚŹěŹě ě ę˛ě ëí ëśë´ęłź ě

돴 íźëĄë뼟 ěŚę°ěěź ěë°Šě ę˛ě ëí ě§ě´ ę°ěí ě°ë ¤ę° ěë¤. ěŚ, 모ë ěë°Šě ę˛ě ěë°Šěě¤ ě ę˛ěę° ě§ě ěíí기ěë ě¸ë Ľ ë° ěě¤í

ě 츥늴ěě ě´ë ¤ěě´ ěë¤(

3). 기쥴ě ěë°Šě ę˛ě ěë ëĄęˇ¸ ë°ŠěěźëĄ ě§íëęł ěěźëŠ°, ě ę˛ ę˛°ęłźëĽź ěę¸°ëĄ ěěąíěŹ ě ëŹíë¤. ě´ëŹí 기쥴ě ě ę˛ě ëë ë°ě´í°ë˛ ě´ě¤íëě´ěě§ ěě íě ě˛ëŚŹě ëí ě§ě°ě´ ë°ěí ě ěě´ ě ěí ě˛ëŚŹę° íěí ě¤ë ěíěě¸ ěíŠěě ë°Ší´ ěěëĄ ěěŠíë¤. ë°ëźě ěë°Šě ę˛ ěě¤í

ě ëí 기ě ě ě¸ ę°ě ë°Šěě´ íěíë¤.

ëĽëŹë 기ë°ě ě¤ěę° ę°ě˛´íě§ ę¸°ě ě´ ë°ě í¨ě ë°ëź ěŹë ë° ěě ę´ë ¨ ëśěźě ě´ëĽź ě ěŠí ě°ęľŹë¤ě´ ě§íëęł ěë¤. closed-circuit television (CCTV)ě íľí´ ě´Źěëë ěěěě íěŹ, ěŹë ëąě ě¸ěíěŹ ě¤ěę°ěźëĄ ěŹë ë° ěě ę´ëŚŹę° ę°ëĽí ěě¤í

(

4)ęłź ěíěŹęł ę° ëšë˛íę˛ ë°ěíë ęą´ě¤íěĽęłź ę°ě ęłłěě ěě ę´ëŚŹëĽź ěí´ ěě 모ě ęą´ě¤ę¸°ęłëĽź ëĽëŹëě íěŠíěŹ íě§íë 모ë¸ě ę´í ě°ęľŹ(

5)뼟 ěëĄ ë¤ ě ěë¤. ě¤ë´ ěë°Šěě ęłź ę´ë ¨í´ěë ě§í ęłľë꾏ěě ë°ěíë íěŹëĽź ë°Šě§í기 ěí´ ëĽëŹëě íěŠí ěŹëĄë ěë¤. ě§í ęłľë꾏ë 긴 ě°ěĽě ęľŹěĄ°ëŹźě´ ě°ěě ěźëĄ ě¤ěšëě´ ěě´ ěě

ěě ěěšě ěí기ě ěěšëĽź ě íí íë¨í기 ě´ë ľë¤. íě§ë§ íěŹę° ë°ěí ę˛˝ě° ěë°Šě¤ëšě ëí ěěš íě

ě´ íěŹě ě´ę¸° ě§ěě ěí´ěë ě¤ěí ěěëĄ ěěŠíë¤. ě´ëĽź ěí´ ě§í ęłľë꾏ě ëí ëě§í¸ í¸ě 모ë¸ě 꾏ěśíěŹ ě¤ěę°ěźëĄ íěŹ ë°ěě ěśě íęł , ěí기ě ěěšëĽź íě

íěŹ ęłľë꾏 ěě

ěěę˛ ëš ëĽ´ę˛ ě ëŹí ě ěëëĄ ěě¤í

ě 꾏ěśíěë¤. ě´ë ě§í ęłľę°ě ě¤ěšë CCTV ěěě ë°íěźëĄ ęłľë꾏ě 꾏쥰뼟 íěľíěěźëŠ°, ěí기ě ę˛˝ě° CCTV ěěěě ěśěśí ë°ě´í°ëĽź ěŹěŠíěŹ ę°ě˛´ě¸ě íë 모ë¸ě íěľíěë¤. ě´ë ěŹěŠí ę°ě˛´ě¸ě 모ë¸ě ě¤ěę° ę˛ěśě ěí´ 1-stage detector ë°Šěě ě´ěŠíěěźëŠ°, CCTVę° ě¤ěšë ěěšě ë°ëź ě´Źěë ěí기 ě´ëŻ¸ě§ëĽź 깰댏ëłëĄ 꾏ëśíěŹ ëŞ¨ë¸ě í

ě¤í¸í늰 ě°ęľŹëĽź ě§ííěë¤(

6).

ě´ě˛ëź íěŹ ë° ěŹëěźëĄëśí° ěě ě ěí´ ě¸ęłľě§ëĽě íěŠí ě°ęľŹę° ë§ě´ ě§íëęł ěě§ë§, ěë°Šěě¤ ě ę˛ě ěí ě ę˛ě ëě 기ě ě 츥늴ě ě ëě ě¸ ě°ęľŹë 미미í ě¤ě ě´ë¤. ë°ëźě 본 ë

źëŹ¸ěěë ěě ě´í´ëł¸ 기쥴ě ěë°Šěě¤ě ę˛ ě ëě ëí 돸ě ě ě í´ę˛°íęł í¨ě¨ě ě¸ ě ę˛ě ě§ěí기 ěí´ ěŚę°íě¤ęłź ëĽëŹë ěęł ëŚŹěŚě íěŠí ěë°Šěě¤ ě ę˛ ěě¤í

ě ě ěíë¤.

2. ě ę˛ ěě¤í

2.1 ěë°Šěě¤ ě ę˛ ěě¤í

ěí¤í

ě˛

본 ěĽěěë ěë°Šěě¤ ě ę˛ ěě¤í

ě 꾏쥰 ë° ę¸°ëĽě ę´í´ ě¤ëŞ

íë¤. ě ěíęł ě íë ě ę˛ ěě¤í

ě augmented reality (AR) ę¸ëě¤ëĽź ě´ěŠíěŹ ě¤íí늰,

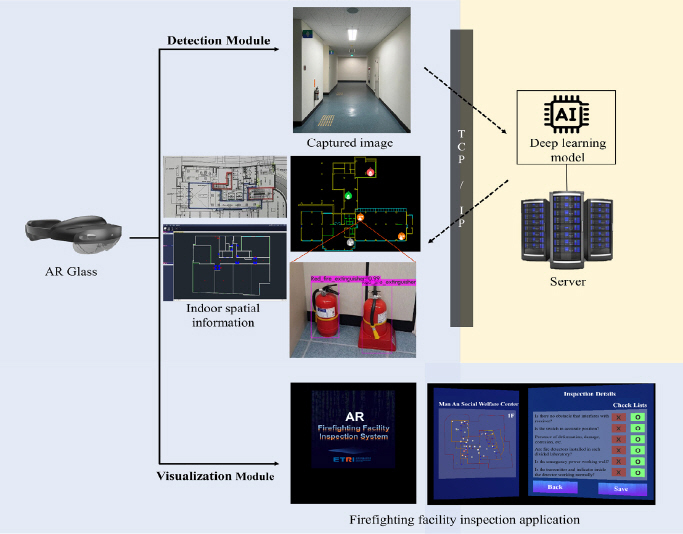

Figure 1ęłź ę°ě´ ěě¤í

ě 꾏쥰ë ë ę°ě§ 모ëëĄ ęľŹëśíë¤. detection moduleěěë ě ę˛ě ě§ííęł ě íë ěë°Šěě¤ëŹźě ëĽëŹë 모ë¸ě íľí´ ę°ě˛´ ě¸ěíęł , ꡸ 결곟뼟 ěě¤í

ě ě ëŹíěŹ ě ę˛ ěí뼟 ě

ë°ě´í¸íë¤. ě ę˛ěë ě

ë°ě´í¸ë 결곟뼟 visualization moduleě¸ ěë°Šěě¤ ě ę˛ ě í댏ěźě´ě

ě íľí´ íě¸í ě ěěźëŠ°, ě´ëĽź ë°íěźëĄ ěë°Šěě¤ëŹźě ëí ě ę˛ í몊ě íę°íë¤. ěë°Šěě¤ëŹź ę°ě˛´ ě¸ě ëŞ¨ë¸ ęľŹěśě ëí´ěë ë¤ě ěĽěě ë¤ëŁŹë¤.

Figure 1

System architecture of firefighting facilities inspection system.

2.1.1 Detection Module

ěë°Šěě¤ ě ę˛ ěě¤í

ěě ěë°Šěě¤ëŹźě ě¸ěí기 ěí´ ëĽëŹë 모ë¸ě íěľíěŹ ěë°Šěě¤ëŹźě ëí ę°ě˛´ ě¸ěě ěííë¤. AR ëë°ě´ě¤ě ěš´ëŠëźëĽź íľí´ 캥ěłë ěë°Šěě¤ëŹź ě´ëŻ¸ě§ë ěë˛ëĄ ě ëŹëě´ ëĽëŹë 모ë¸ëĄ ë¤ě´ę°ęł , ě´ë¤ ěë°Šěě¤ëŹźě¸ě§ íě§íěŹ ę˛°ęłźëĽź ěśë Ľíë¤. ě´ëŻ¸ě§ 기ë°ě ëĽëŹëě 모ë¸ě 꾏쥰ě ë°ëź ëě ęłě°ëě´ ě꾏ë늰 ę°ě˛´ ě¸ěě ěíí기 ěí´ěë ëĽëŹë 모ë¸ě ęłě°ëě ę°ëší ě ěë ěě¤ě graphic processing unit (GPU)ę° íěě ě´ë¤. 본 ěě¤í

ěěë ëěą ëš ëĽ´ęł ě ě°í ě°ě° ě˛ëŚŹëĽź ěíí기 ěí´ AR ëë°ě´ě¤ę° ě§ěíë ę˛ëł´ë¤ ëě ěąëĽě GPU뼟 íěŹí ěë˛ëĽź ěŹěŠíë¤. ě´ë ěë˛ě AR ëë°ě´ě¤ë transmission control protocol/internet protocol (TCP/IP) íľě ë°Šěě íľí´ ě´ëŻ¸ě§ě ę°ě˛´ ě¸ě 결곟뼟 ěŁźęł ë°ëë¤. TCP/IP íľě ë°Šěě ěë˛ě ëë°ě´ě¤ ę°ě íľě ě ěí ěěźě ěěąíęł IP 죟ě, íŹí¸ ë˛í¸ě ę°ě 죟ě ě 보뼟 í ëšíë¤. ěě¤í

ě ěë˛ ěŁźěě ě ꡟíěŹ ěěźě ě°ę˛°í늴 ěëĄ íľě í늰 ë°ě´í°ëĽź ěŁźęł ë°ě ě ěę˛ ëë¤.

2.1.2 Visualization Module

ěŚę°íě¤ ę¸°ë° ěë°Šěě¤ ě ę˛ ěě¤í

ě AR ëë°ě´ě¤ëĽź íľí´ ěŹěŠí기 ěí´ ě ëí° í경ě ë°íěźëĄ ěě¤í

ě user interface /user experience (UI/UX)뼟 꾏ěśíë¤. 깴돟ě ěë ěë°Šěě¤ëŹźě í¨ě¨ě ěźëĄ ę´ëŚŹí기 ěí´ěë ěě¤ëŹźě´ ě¤ěšë ěěšě ě 보뼟 ě ííę˛ íě

íë ę˛ě´ ě¤ěíë¤. ě´ëĽź ěí´, 돸ěëĄ ěĄ´ěŹíë 깴돟ě ë늴ě ëě§í¸ ë늴ěźëĄ ě ěíęł ěě¤ëŹźě ěěšëĽź point of internet (POI) ě 보뼟 ë°íěźëĄ 매ííěŹ ě ę˛ěěę˛ ě ęłľíë¤. 깴돟ě ëí 2D/3D ęłľę°ě ëł´ě ę°ě˛´ě 보뼟 ěě§íěŹ ëëŠ´ěŠ XMLě ěěąíęł , ë늴ě ě ěí기 ěí´ ë˛˝, 돸, 창돸 ëąě ěě뼟 ë°íěźëĄ ěę°ííë¤. ěěąë ëě§í¸ ë늴ěë ěë°Šěě¤ëŹźě ěěš ě 보뼟 매ííęł , ěě¤ëŹź ëł ěě´ě˝ě ěěąíěŹ ë늴ě ę°ěííěŹ ěě¤í

ěě ě ę˛ěę° ěě¤ëŹźě ëł´ë¤ ě˝ę˛ íě

í ě ěëëĄ íë¤. 본 ěě¤í

ěěë ě´ 5ę°ě§ ěë°Šěě¤ëŹźě¸ ëśěě ěí기, ěě ěí기, ěíě , ě°ę¸°ę°ě§ę¸°, ëšě꾏 ě ëëąě ëí ě ę˛ě ě§ěí늰, ě ę˛ ě ěë°Šěě¤ëŹźě ěě´ě˝ě ěíě ë°ëź ěěě ë¤ëĽ´ę˛ 꾏ëśíěŹ ě ę˛ ěí뼟 íě

í ě ěëëĄ íěë¤. ě ę˛í기 ě ě ěë°Šěě¤ëŹźě íěěźëĄ íěë늰, ę°ě˛´ ě¸ěë ěë°Šěě¤ëŹźě 죟íŠěěźëĄ íěë늰 ěě´ě˝ í´ëŚ ě ěë°Šěě¤ě ě ę˛í ě ěë íëŞŠě´ ěśë Ľëë¤. ěë°Šěě¤ ě ę˛ í몊ě ëí íę°ëĽź ěëŁí늴 ě ę˛ ěíě ë°ëź ěě´ě˝ě ěěě´ ëłę˛˝ëë¤. ě ę˛ ěíę° ě ěěź ę˛˝ě° ë

šě, ě ę˛ í몊 ě¤ 1ę° ě´ěě´ ëśëěź ę˛˝ě° ëš¨ę°ěěźëĄ íěëë¤.

2.2 ěë°Šěě¤ ě ę˛ ę°ě˛´ě¸ě íěľëިë¸

본 ë

źëŹ¸ěě ě ěí ěë°Šěě¤ ě ę˛ ěě¤í

ě ëĽëŹë 모ë¸ě íěŠíěŹ ěë°Šěě¤ëŹźě ěëěźëĄ ę°ě˛´ě¸ě íěŹ ě ę˛ě ěíí ě ěëëĄ ę°ě˛´ě¸ě 모ë¸ě íěľíěŹ ěŹěŠíë¤. ě°ě 본 ě ěěë 기쥴 ě°ęľŹěěë ěí기 2ě˘

, ěĽë´ ěíě , íěŹ ę°ě§ę¸°, ëšě꾏 ě ëëąěźëĄ 꾏ěąë 5ě˘

ě ěë°Šěě¤ëŹź ë°ě´í°ě

ě ě§ě 꾏ěśíěŹ ëŞ¨ë¸ě íěľí 결곟ě ëí´ ě¤ëŞ

íë¤. ë¤ěěźëĄ AI huběě ęłľę°í ë°ě´í°ě

ě¸ ë¤ě¤ë°ě§ěě¤ ë° ěŁźęą°ěě¤ íěŹ ěě ë°ě´í°ě

ě ë°íěźëĄ íěľí ěë°Šěě¤ëŹź ę°ě˛´ě¸ě 모ë¸ě íěľ ë° ěąëĽě ëí´ ě¤ëŞ

íęł ę¸°ěĄ´ě ě§ě 꾏ěśí ë°ě´í°ě

ěźëĄ íěľí 모ë¸ęłź ꡸ 결곟뼟 ëšęľ ëśěíë¤.

ë¤ě¤ë°ě§ěě¤ ë° ěŁźęą°ěě¤ íěŹ ěě ë°ě´í°ě

ě ěŹěŠí ę°ě˛´ ě¸ě 모ë¸ě ë ę°ě§ ěŹíě ęł ë ¤íěŹ ě¤íě ě¤ęłíěë¤. 첍 ë˛ě§¸ëĄë ę°ę°ě ěë°Šěě¤ëŹźě ę°ě˛´ ě¸ěí ě ěëëĄ ě¤ě ë°ě´í°ě

ë§ě ě´ěŠíěŹ íěľí í í´ëě¤ëł average precision (AP)ě mean average precision (mAP)뼟 ë°íěźëĄ 모ë¸ě ěąëĽęłź íěľě ě í¨ěąě ëśěíë¤. ë ë˛ě§¸ ě¤íě ě¤ěě 미ě¤ě뼟 꾏ëśí ě ěëě§ě ëí´ íë¨í기 ěí´ ę° ë ě´ë¸ëł ě¤ě, 미ě¤ě ë°ě´í°ëĽź íěľí í 첍 ë˛ě§¸ ě¤íęłź ę°ě´ ëŞ¨ë¸ ěąëĽ íę° ë° ëśěě ěííë¤.

2.2.1 ě체 ęľŹěś 5ě˘

ěë°Šěě¤ëŹź ë°ě´í°ě

íěľ ëŞ¨ë¸(7)

댏ë

ě¤ ę¸°ë°ě ě°ëśíŹ(Ubuntu 16.04)ě YOLO íěľě ěí darknet framework뼟 꾏ěąíęł , GPU (NVIDIA GeForce GTX 1080 Ti), Python (3.7.10), CUDA (11.1), cuDNN (8.0.5), OpenCV (4.4.0)ě ę°ě´ íěľ í경ě 꾏ěąíěŹ ě¤íě ě§ííë¤.

ěë°Šěě¤ëŹź ě ę˛ ěě¤í

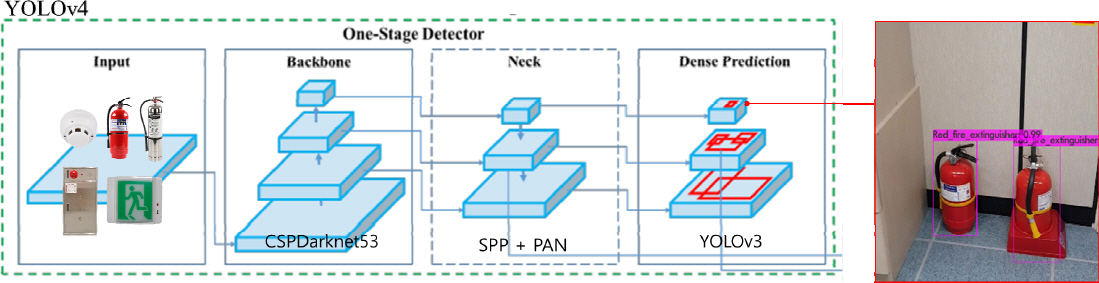

ě íěŠë ëĽëŹë 모ë¸ě ě¤ěę°ěźëĄ ěŚę°íě¤ ëë°ě´ě¤ëĄëśí° ě´ëŻ¸ě§ëĽź ë°ě ěë˛ëĄ ě ëŹíěŹ ę°ě˛´ ě¸ěě ěíí´ěź íë¤. ë°ëźě ëš ëĽ´ęł ě ííę˛ ę°ě˛´ëĽź íě§í ě ěë 1-stage detector 기ë°ě YOLO(

8) ěęł ëŚŹěŚě íěľëިë¸ëĄ ě ííěë¤. 1-stage detectorë ę°ě˛´ ě¸ěě íëě íęˇ ëŹ¸ě ëĄ ě ꡟíěŹ ě´ëŻ¸ě§ ë´ě ę°ě˛´ëĽź ě°žě bounding box뼟 ě츥íęł ëěě ě´ë¤ ę°ě˛´ě¸ě§ íëĽ ě ęłě°íěŹ ëśëĽíë¤. 모ë¸ě 꾏쥰 ëí 기쥴ě R-CNNęłź ę°ě 2-stage detectorě ëší´ ę°ë¨í기 ë돸ě ě˛ëŚŹ ěëę° ëš ëĽ´ęł ě¤ěę° ę°ě˛´ ě¸ěě ě íŠíë¤.

본 ě°ęľŹěě ěŹěŠë YOLOv4(

9)ë darknet framework 기ë°ěźëĄ ę°ë°ëěěźëŠ° ěě 돟체ě ëí ě¸ě ěąëĽě ëě´ęł íěľ ěë ě§ě° 돸ě 뼟 í´ę˛°í 모ë¸ě´ë¤. ě´ě 모ë¸ě¸ YOLOv3ě backboneě CSPDarknet53ěźëĄ ě¤ęłíęł , SPPě path aggregation network (PAN)뼟 ě ěŠí´ 기쥴 ëëš APę° 10% ě ë íĽěë ěąëĽě ëł´ěŹě¤ë¤.

Figure 2ěě YOLOv4ě íěľ íëĄě°ëĽź íě¸í ě ěë¤. ě´ë, 모ë¸ě ë¤í¸ěíŹ ęľŹěĄ° ěěě ę°ě˛´ëĽź ě¸ěíěŹ ë°ě´ëŠ ë°ě¤ëĽź ěěąíë ę˛ě dense predictioněě 꾏íëë¤. Anchor 기ë°ěźëĄ ë°ě´ëŠ ë°ě¤ëĽź ě츥í늰, Neck ë¤í¸ěíŹěě ěěąë ěľě˘

feature mapěě ě

ë Ľ ě´ëŻ¸ě§ ěě 쥴ěŹíë ę°ě˛´ëĽź ěśëĄ í ë°ě¤ě ě˘íě ě¤ěŹëśě ě˘í, ęˇ¸ëŚŹęł ë°ě¤ ë´ě ëŹźě˛´ę° ěĄ´ěŹíë íëĽ ę°ě¸ confidence scoreě ë°íěźëĄ ě¸ěí ę°ě˛´ě ë ě´ë¸ęłź í¨ęť íěíë¤.

Figure 2

Learning flowchart of YOLOv4 model.

YOLOv4 Tiny(

10) 모ë¸ě YOLOv4ě 경ëíë ë˛ě ěźëĄ íëě¨ě´ě ěąëĽě´ ëŽě ěë˛ ëëě ę°ě í경ěěë í¨ě¨ě ěźëĄ 꾏íë ě ěëëĄ ěľě íë 모ë¸ě´ë¤. ě ěë ěë°Šěě¤ ě ę˛ ěě¤í

ě ěë˛ěěě íľě ě íľí´ ę°ě˛´ëĽź ę˛ěśíęł ěě§ë§, ěśí ěë˛ëĽź ěŹěŠíě§ ěęł ë¨ěź ëë°ě´ě¤ë§ěźëĄ ěě¤í

ě ěŹěŠí ě ěëëĄ ę˛˝ëíě ę´í ě°ęľŹë íěíë¤. ë°ëźě 경ëíë 모ë¸ě¸ YOLOv4 Tiny뼟 íěľíěŹ ěě¤í

ě ě ěŠí ě ěëě§ě ëí´ ę˛°ęłźëĽź ëšęľ ëśěíë¤.

모ë¸ě íěľí기 ěí´ ěŹěŠí ëŞ¨ë¸ íëźëŻ¸í°ë AlexyAB(

9)ę° ě ěí ë°Šë˛ě ë°ëź ě¤ě íěŹ ě ěŠíěë¤. íěľ ě´ëŻ¸ě§ě input sizeë 416 Ă 416ě´ëŠ°, max_batchesě ę˛˝ě° íěľí í´ëě¤ě ę°ě Ă 2000ěźëĄ ě ěíěŹ íěľí 5ě˘

ě í´ëě¤ëĽź ęłąí ę°ě¸ 10,000ěźëĄ ě¤ě íěë¤. learning rateë 0.001, confidence thresholdë 0.5ëĄ ě¤ě íęł , ěŹě íěľë yolo.conv137 모ë¸ě íěľ weightëĄ ěŹěŠíěë¤. ě´ëŹí ě¤ě ě YOLOv4ě YOLOv4 Tiny 모ë ę°ë¤. íěľě ěŹěŠë ë°ě´í°ě

ě íěľęłź ę˛ěŚ ë°ě´í°ëĽź 8:2ě ëšě¨ëĄ ëë ěŹěŠíěěźëŠ° ěě¤ëŹźëł íěľ í´ëě¤ ëŞ

ěšęłź ë°ě´í°ě

ě

Table 1ěě ě¤ëŞ

íë¤.

Table 1

5 Types of Firefighting Facility Dataset

|

Class |

Class ID |

Number of Images (100%) |

|

Red Fire Extinguisher |

1 |

440 |

|

Silver Fire Extinguisher |

2 |

290 |

|

Fireplug |

3 |

707 |

|

Exit Sign |

4 |

1465 |

|

Fire Detector |

5 |

1501 |

ę° ëŞ¨ë¸ě íěľ ę˛°ęłź, YOLOv4 모ë¸ě mAPë 93.6%ëĄ YOLOv4 Tiny 모ë¸ě mAPě¸ 92.83%ëł´ë¤ ëěěźëŠ°, í´ëě¤ëł AP ëí YOLOv4ę° ëŞ¨ë í´ëě¤ěě ëě ěąëĽě ëł´ěë¤. ë ëŞ¨ë¸ ëŞ¨ë Class IDę° 1ě¸ ëśěě ěí기ě ëí ěąëĽě´ ę°ę° 74.43%, 73.51%ëĄ ę°ěĽ ëŽę˛ 츥ě ëěěźëŠ°, ëë¨¸ě§ í´ëě¤ě ëí ěąëĽě 96.34~99.06%ě ěąëĽě ëł´ěŹěŁźěë¤(

Table 2)(

11).

Table 2

Training Results of YOLOv4 and YOLOv4 Tiny Model

|

Model*

|

AP (%) by Class ID |

mAP@0.5 (%) |

|

1 |

2 |

3 |

4 |

5 |

|

YOLOv4 |

74.43 |

98.16 |

99.06 |

98.38 |

98.17 |

93.60 |

|

YOLOv4 Tiny |

73.51 |

96.34 |

98.96 |

97.99 |

97.53 |

92.83 |

ëśěě ěí기ě ëí ě íëę° ëŽę˛ 츥ě ë ě´ě 뼟 íě

íęł ě ë°ě´í°ě

ě íě¸í´ëł¸ 결곟, ë¤ëĽ¸ í´ëě¤ě ëší´ ěí기ě ëí ę°ě˛´ę° ë¤ëĽ¸ 돟체ě ę°ë ¤ě ¸ ěęą°ë ěźëśë§ ě°í ę°ě˛´ě ě 체ě ě¸ ííę° ëł´ěĄ´ëě§ ëŞťí ě´ëŻ¸ě§ę° ě˝ 30% ě´ě 쥴ěŹíěë¤. ëí, ë¤ëĽ¸ ë ě´ë¸ęłź ëšęľíěě ë ë°ě´í°ě ę°ěë ě ě´ ë¤ëĽ¸ ë°ě´í°ě

ě ëší´ íě§ě ěźëĄ ë¨ě´ě§ ę˛ě´ íěľ ę˛°ęłźě ěíĽě ě¤ ę˛ě´ëźë ę˛°ëĄ ě ë´ëŚ´ ě ěěë¤. ě´ëĽź ëł´ěí기 ěí´ěë ë°ě´í°ě íě§ě ëě´ęą°ë ë°ě´í°ě ěŚę°ě íľí´ íěľíë¤ëŠ´ ę¸°ěĄ´ëł´ë¤ íĽěë 결곟뼟 ěťě ě ěě ę˛ě´ë¤. ë°ëźě ë¤ě ěĽěě 꾏ěśë ë°ě´í°ě

ëł´ë¤ ęˇëŞ¨ę° íŹęł íě§ë ëě ęłľęłľë°ě´í°ě

ě íěŠíěŹ ëŞ¨ë¸ě íěľíęł ę˛°ęłźëĽź ëěśí´ ëł´ë ě¤íě ě§ííěë¤.

2.2.2 ë¤ě¤ë°ě§ěě¤ ë° ěŁźęą°ěě¤ íěŹ ěě ë°ě´í°ě

íěľ ëŞ¨ë¸

ë¤ě¤ë°ě§ěě¤ ë° ěŁźęą°ěě¤ íěŹ ěě ë°ě´í°ě

ě ěŹěŠí ę°ě˛´ ě¸ě 모ë¸ě ë ę°ě§ ěŹíě ęł ë ¤íěŹ ě¤íě ě¤ęłíěë¤. 첍 ë˛ě§¸ëĄë ę°ę°ě ěë°Šěě¤ëŹźě ę°ě˛´ ě¸ěí ě ěëëĄ ě¤ě ë°ě´í°ě

ë§ě ě´ěŠíěŹ íěľí í í´ëě¤ëł APě mAP뼟 ë°íěźëĄ 모ë¸ě ěąëĽęłź íěľě ě í¨ěąě ëśěíë¤. ë ë˛ě§¸ë ěë°Šěě¤ëŹźě ě¤ěě 미ě¤ě ěí뼟 꾏ëśí ě ěëě§ě ëí´ íë¨í기 ěí´ ę° ë ě´ë¸ ëł ě¤ě, 미ě¤ě ë°ě´í°ëĽź íěľí í 첍 ë˛ě§¸ ě¤íęłź ę°ě´ ëŞ¨ë¸ ěąëĽ íę° ë° ëśěě ěííë¤. ě´ë ěŹěŠë ëĽëŹë 모ë¸ě 기쥴ě 모ë¸ëł´ë¤ ěąëĽęłź ěë 늴ěě ë°ě ë 모ë¸ě¸ YOLOv5ě´ë¤.

본 ë°ě´í°ě

ě ě´ 22ě˘

ě ěë°Šěě¤ëŹźëĄ 꾏ěąëě´ ěě§ë§, ë

źëŹ¸ěě ě ěíë ěě¤í

ě ěí기, ěíě , ě°ę¸°ę°ě§ę¸°, íźë꾏 ě ëëą, íľëĄ ě ëëąě¸ 5ę°ě§ëĽź ě´ěŠíěŹ íěľě ěŹěŠíěë¤. ě´ë ěíě í¨ě˛´ě ę˛˝ě° ë ę°ě§ ë ě´ë¸ëĄ ëëě´ ë°ě´í°ě

ě´ ęľŹěąëě´ ěë¤. ë°ëźě íěľě ěŹěŠë ë°ě´í°ě ë ě´ë¸ě ě´ 6ę°ě´ë¤. ěë°Šěě¤ ě˘

ëłëĄ ě¤ěě 미ě¤ě ë°ě´í°ëĄ 꾏ěąëě´ ěěźëŠ°, ěě¤ëŹź ëł ëŻ¸ě¤ě ěě¸ ěŹě ë ëśě, ëłí ëąě´ ěë¤(

12).

(1) ě¤í 1. ě¤ě ěë°Šěě¤ëŹź ë°ě´í°ě

ě ě´ěŠí YOLOv5 ëŞ¨ë¸ íěľ

YOLOv5(

13)ë YOLOv4(

9)ě ę°ě´ CSPDarknet53 기ë°ě backboneěźëĄ ě¤ęłëěěźëŠ°, Darknet íę˛˝ě´ ěë PytorchëĄ ęľŹíë 모ë¸ě´ë¤. ěąëĽě ě¸ ě¸ĄëŠ´ěěë YOLOv4ě ëšěˇíě§ë§, 모ë¸ě´ 경ëíëęł íěľ ěëë 뚨ëźě§ ěĽě ě´ ěë¤. YOLOv5ë 모ë¸ě íŹę¸°ě ë°ëź nano (n), small (s), medium (m), large (l), xlarge (x)ëĄ ęľŹëśí늰, íŹę¸°ę° ěěěëĄ íěľ ěëë ëš ëĽ´ęł , í´ěëĄ ěëë ë댏ě§ë§ ě íëë ëěě§ë¤.

본 ě¤íě YOLOv5s 모ë¸ě Pytorch 1.7 í경ěě íěľě ě§íí늰, íěľ íëźëŻ¸í°ë ě

ë Ľ ě´ëŻ¸ě§ íŹę¸°(image size) 640 Ă 640, ë°°ěš íŹę¸°(batch size) 16, ęˇ¸ëŚŹęł epochë 100ěźëĄ ě¤ě íěë¤. íěľęłź ę˛ěŚě ë°ě´í°ě

ě 8:2ě ëšě¨ëĄ ëë ěŹěŠíë¤. íěľí ěë°Šěě¤ëŹźě 꾏ěąě ěí ěí기, ěíě í¨ě˛´(ëŤí), ěíě í¨ě˛´(ě´ëŚź), ě°ę¸°ę°ě§ę¸°, íźë꾏 ě ëëą, íľëĄ ě ëëąěźëĄ 6ě˘

ě´ëŠ°, ěí ěí기ě ę˛˝ě° ëśěě ěí기ë§ě íěľíë¤.

Table 3ěěě ę°ě´ YOLOv5sě íěľ ę˛°ęłź ěíě í¨ě˛´(ëŤí)ě APę° 87.4%ëĄ ę°ěĽ ëŽěęł , íźë꾏 ě ëëąęłź íľëĄ ě ëëąě APę° 97.6%ëĄ ę°ěĽ ëěë¤. 모ë¸ě ěąëĽě mAP 93.6%ëĄ ěë°Šě ę˛ ěě¤í

ě ěŹěŠ ě¤ě¸ YOLOv4 모ë¸ě ěąëĽęłź ëěźíë¤. 모ë¸ě ë¤í¸ěíŹ íŹę¸°ëĽź ęł ë ¤íěě ë YOLOv5sę° YOLOv4ëł´ë¤ ę˛˝ëíëě´ěęł , ë ëŞ¨ë¸ ę°ě ěąëĽ ě°¨ě´ë ě기 ë돸ě 기쥴 ěě¤í

ě ě ěŠí ě ěě ě ëě íźíŹë¨źě¤ëĽź ëł´ěŹěŁźë ę˛ě íě¸í ě ěěë¤.

Figure 3ě YOLOv5sě ę°ě˛´ ě¸ě í

ě¤í¸ 결곟ě´ë¤.

Table 3

Training Results of Complaint Firefighting Facility Dataset Using YOLOv5 Model

|

Model*

|

Class Name |

Instances |

AP (%) |

mAP@0.5 (%) |

|

YOLOv5s |

FireExtinguisher |

3073 |

92.5 |

93.6 |

|

Indoor_Fire_Hydrant_Close |

2458 |

87.4 |

|

Indoor_Fire_Hydrant_Open |

3002 |

89.2 |

|

Smoke_Detector |

2524 |

97.3 |

|

Fire_Escape_Light_Refuge |

2295 |

97.6 |

|

Fire_Escape_Light_Aisle |

2264 |

97.6 |

Figure 3

(a) Result of firefighting facility detection model, (b) Result of compliance and non-compliance object detection model.

(2) ě¤í2. ěí ěí기 ě¤ě/미ě¤ě ęľŹëś ëŞ¨ë¸ íěľ

ě¤í 1ěě ë¤ě¤ë°ě§ěě¤ ěë°Šěě¤ëŹź ë°ě´í°ě

ě íěľ ě í¨ěąě íě¸í ě ěěë¤. ě´ě ë°ëź, ě¤ěě 미ě¤ě ë°ě´í°ě

ě íěŠíěŹ ěë°Šěě¤ě ěí뼟 꾏ëśí ě ěëě§ě ëí ě¤íě ě§ííë¤. ěě íěľí ěë°Šěě¤ ě¤ ě¤ě/미ě¤ě ë°ě´í° ę°ěę° ę°ěĽ ë§ě ěí ěí기ě ëí´ ëŞ¨ë¸ě íěľíë¤.

íěľ í경ě ě¤í 1ęłź ëěźí늰, íěľě ěŹěŠí ěë°Šěě¤ëŹźě í´ëě¤ ëŞ

ě ěí ěí기(ě¤ě)ě ę˛˝ě° FireExtinguisher_OK, ěí ěí기(미ě¤ě)ě ę˛˝ě° FireExtinguisher_FailëĄ í기íë¤. ěí ěí기ě 미ě¤ě ěŹě ë ëśě, ěíę¸°ę° ěěší ęłłě í기í´ěŁźë íě§ę° ěë 경ě°ě¸ ěě¸ěą ëśěĄą(íě§ íŹí¨), ěí기 í¸ěę° ěë ëąě 기í ëłí(ěě íŹí¨)ě´ëŠ°, 미ě¤ě ěŹě ě ë°ëź í´ëě¤ëĽź 꾏ëśíě§ë ěëë¤.

íěľí 모ë¸ě í

ě¤í¸í 결곟 ěí ěí기(ě¤ě)ë 93.7%, ěí ěí기(미ě¤ě)ë 90.2%ě ě íë뼟 ëł´ěë¤. 모ë¸ě mAPë 91.9%ëĄ ëŻ¸ě¤ě ě´ëŻ¸ě§ě ëśíŹë ëśě 0.14%, ěě¸ěą ëśěĄą(íě§ íŹí¨) 50.80%, ëłí(ěě íŹí¨) 49.00%ëĄ, ëśě ë°ě´í°ę° ę°ěĽ ě ě´ í

ě¤í¸ëĄ íě¸í기ě íęłę° ěěë¤(

Table 4). íě§ë§, ěě¸ěą ëśěĄą(íě§ íŹí¨)ęłź ëłí(ěě íŹí¨) ěŹě ě ëí íěľ ę˛°ęłźë

Figure 3ě (b)ě ę°ě´ ě 꾏ëśíë ę˛ě íě¸í ě ěë¤. ě´ëŹí 결곟뼟 ë°íěźëĄ ěë°Šěě¤ëŹźě ě¤ě/미ě¤ě ë°ě´í°ě

ě´ ęľŹěśëë¤ëŠ´, íěľě íľí´ ěě¤ëŹźě ěí뼟 꾏ëśí ě ěë 모ë¸ě ę°ë°í ě ěë¤ë ę°ëĽěąě íě¸í ě ěěë¤. ë ëěę° ěë°Šěě¤ëŹź ě¸ę´ě ę˛ě 돴ě¸í뼟 ěí 모ë¸ëĄě¨ íěŠíěŹ ę¸°ěĄ´ě ěë°Šěě¤ ě ę˛ěě ě ę˛ í¨ě¨ěąě ěŚę°ěíŹ ě ěě ę˛ěźëĄ 기ëëë¤.

Table 4

Training Results of Comp YOLOv5 Model Using the Compliant Fire Facility Dataset

|

Model*

|

Class Name |

Instances |

AP (%) |

mAP@0.5 (%) |

|

YOLOv5s |

FireExtinguisher_OK |

1559 |

93.7 |

91.9 |

|

FireExtinguisher_Fail |

1327 |

90.2 |

2.3 ěŚę°íě¤ ěë°Šěě¤ ě ę˛ ěě¤í

꾏í

Figure 4ë 본 ë

źëŹ¸ěě ě ěí ëĽëŹë ę¸°ë° ěŚę°íě¤ ěë°Šěě¤ ě ę˛ ěě¤í

ě íëĄë ěŚ 2ěě ě¤ííěŹ ěë°Šěě¤ ě ę˛ě ěíí ęłźě ě ëł´ěŹě¤ë¤. AR ëë°ě´ě¤ě¸ íëĄë ěŚëĽź ě°ŠěŠí ë¤ ě ę˛ ěě¤í

ě ě¤ííęł ě ę˛ě 모ëě ę´ëŚŹě 모ë ě¤ ě ííë¤. ě°ě ěë°Šěě¤ ě ę˛ě ěí´ ě ę˛ě 모ëëĄ ě§ě

íë¤. ě ę˛ě ěíí 깴돟곟 츾ě ě ííęł í늴ě íěë ë늴(ě§ë)ěě ě ę˛í ěë°Šěě¤ëŹźě ě ííë¤. íëĄë ěŚě ěš´ëŠëźëĽź íľí´ ěë°Šěě¤ëŹźě ě¤ěşíěŹ ëĽëŹë 모ë¸ě íľí´ ę°ě˛´ ě¸ěě ěííë¤. ę°ě˛´ ě¸ěě´ ěąęłľě ěźëĄ ě§íëěě ę˛˝ě° ě íí ěë°Šěě¤ëŹźě ěě´ě˝ě ěěě 죟íŠěěźëĄ ëłę˛˝ëë¤. ë§ě˝ ę°ě˛´ ě¸ěě´ ëě§ ěě 경ě°, QR scaně ě ííěŹ ěë°Šěě¤ëŹźě ëí QRě˝ë뼟 ě¸ěěěźěŁźë ë°Šë˛ěźëĄë ě ę˛ě ěíí ě ěë¤. ě¸ěë ěë°Šěě¤ëŹź ěě´ě˝(죟íŠě)ě ě íí늴 ěë°Šěě¤ëŹźě ëí ě ę˛ í몊ě íę°í ě ěěźëŠ° ě ę˛ ë°Šë˛ě ëí´ěë ě ę˛ ěě ë˛íźě íľí´ íěľí ě ěë¤. QR scaně ę˛˝ě° ě¸ěě ěąęłľí늴 ěëěźëĄ ě ę˛ íëŞŠě´ ëíëë¤. ě ę˛ě ěëŁí늴 ę´ëŚŹě 모ëěě ě ę˛ ę˛°ęłźëĽź íě¸í ě ěë¤. ę´ëŚŹě íě´ě§ěěë ě ę˛ë 결곟뼟 ěśë Ľí늰, ě ę˛ěźě, ě ę˛ě, ě ę˛ í몊, ě ę˛ ę˛°ęłźę° ě ěĽëě´ ěěźëŠ°, ě ę˛ ę˛°ęłźëĽź ě íí늴 ě ę˛í ěë°Šěě¤ëŹźě ěěšë ë늴ěźëĄ íěíë¤. ëí ěë°Šěě¤ëŹźě íšě´ěŹíě´ ěě 경ě°ě ěŹě§ ě´Źěě íľí´ ëłëëĄ ę¸°ëĄë í ě ěë¤. ěë°Šěě¤ ě ę˛ěë ěĄěěźëĄ ě¸ę´ě ě ę˛íęł ę˛°ęłźëĽź ěę¸°ëĄ ěěąíë 기쥴ě ěë ëĄęˇ¸ ë°Šěě ě ę˛ě´ ěë, 본 ë

źëŹ¸ěě ě ěí ěě¤í

ě íěŠíë¤ëŠ´ ěŚę°íě¤ ëë°ě´ě¤ëĽź ě°ŠěŠíěŹ ë ěě ěě ë뼟 ëě´ęł , ěë°Šěě¤ëŹźě ę°ě˛´ě¸ěíęł ěĄěěźëĄ ě ę˛í¨ěźëĄě¨ ě ę˛ě ëł´ë¤ í¨ě¨ě ě¸ ě ę˛ě ěíí ě ěë¤. ě ę˛ ę˛°ęłźëĽź ë°ě´í°ë˛ ě´ě¤ííěŹ ě ěĽí기 ë돸ě 죟기ě ě¸ ě ę˛ě ěě´ ěë°Šěě¤ëŹźě ěí ë° ě´ë Ľě ę´ëŚŹ ëí í¨ě¨ě ěźëĄ ěíí ě ěë¤.

Figure 4

Augmented reality firefighting facilities inspection system run with Hololens 2.

3. 결 ëĄ

ě°ě

꾏쥰ě ěąěĽě ë°ëź ě¤ëë ë¤ěí ëśěźěě ëě§í¸ ę¸°ë° ę¸°ě ě ë°ě ě´ ëš ëĽ´ę˛ ě§íëęł ěë¤. ě´ě ë°ëź ęą´ě¤ ę¸°ě ëí ëě§í¸ííěŹ ě¤ë§í¸ ę¸°ë° ę¸°ě 꾏ěśěźëĄ ěě¤í

ě´ ěëíëě´ ě ęˇ ęą´ěśëŹźě´ ěŚę°íęł ěë ěśě¸ě´ë¤. ě ęˇ ęą´ěśëŹźě ěŚę°ë ěë°Šěě¤ëŹźě ě¤ěš ěŚę°ëĄ ě´ě´ě§ëŠ°, ě´ë ę´ëŚŹí´ěź í ěë°Šěě¤ëŹźě´ ěŚę°íë ę˛ě ě미íë¤. íěŹě ěŹë ëąěźëĄëśí° ëł´í¸íęł ěë°Šěě ě ěíí기 ěí´ěë ěë°Šěě¤ ę´ëŚŹë íěě ě´ë¤. íě§ë§ íěŹ ęľë´ ěë°Šěě¤ ě ę˛ ěě¤í

ě ěë°Šěě¤ ę´ëŚŹěę° ě ę˛ě ěíí늰 ꡸ 결곟뼟 ěę¸°ëĄ ěěąíë ěë ëĄęˇ¸ ë°Šěě´ë¤. ě´ëŹí ë°Šěě ě ę˛ ěę°ě ěŚę°, ě ę˛ ę˛°ęłźě 체ęłě ę´ëŚŹě ëí ě´ë ¤ě ëąě 돸ě ę° ë°ěíë¤. ë°ëźě ěë°Šěě¤ ě ę˛ ěě¤í

ě ëí ě ëě , 기ě ě ę°ě ë°Šěě´ íěíë¤.

본 ě°ęľŹë ëĽëŹë ěęł ëŚŹěŚě íěŠíěŹ, ěë°Šěě¤ ę´ëŚŹěěę˛ í¸ëŚŹíęł í¨ě¨ě ěźëĄ ěë°Šěě¤ ě ę˛ě ě§íí ě ěëëĄ ę°ě í ě¨ě´ëŹë¸ ëë°ě´ě¤ëĽź íěŠí ëĽëŹë ę¸°ë° ěë°Šěě¤ëŹź ě ę˛ ěě¤í

ě ě ěíěë¤. 기쥴ě ěę¸°ëĄ ěěąíë ě ę˛ ë°Šěęłźë ëŹëŚŹ, ëĽëŹë ěęł ëŚŹěŚě íěŠíěŹ íěľí 모ë¸ě ě ę˛ ěě¤í

ě ě ěŠíěŹ ěë°Šěě¤ëŹźě ę°ě˛´ ě¸ěíęł , ꡸ 결곟뼟 ë°íěźëĄ ěë°Šěě¤ ě ę˛ě ěíí ě ěëëĄ íěë¤.

본 ě ę˛ ěě¤í

ě ě ěŠë ëĽëŹë 모ë¸ě ě§ě 꾏ěśí ěë°Šěě¤ëŹź ë°ě´í°ëĽź ë°íěźëĄ íěľëěěźëŠ°, ę° ëŞ¨ë¸ě ěąëĽě YOLOv4 mAP 93.6%, 경ëí ë˛ě ě¸ YOLOv4 Tiny 모ë¸ě mAPë 92.83%ëĄ í° ě°¨ě´ë ěěë¤. AI huběě ë°íë ë¤ě¤ë°ě§ěě¤ ë° ěŁźęą°ěě¤ íěŹ ěě ë°ě´í°ě

ë 본 ěě¤í

ě ě ěŠí ě ěëě§ě ëí´ ěěëł´ęł ě 기쥴ě 모ë¸ëł´ë¤ ěąëĽě´ íĽěë ë˛ě ě¸ YOLOv5뼟 íľí´ íěľě ě§ííěë¤. ꡸ 결곟 mAP 93.6%ëĄ YOLOv4 모ë¸ě mAPě ę°ěěźëŠ°, ě¤ě/미ě¤ě뼟 꾏ëśíë íěľ ëŞ¨ë¸ě ę˛˝ě° 91.9% ě íë뼟 ěťěë¤. ě´ëĽź ë°íěźëĄ 기쥴 ěě¤í

ě ě ěŠí ě ěě ę°ëĽěąě íě¸í ě ěěěźëŠ°, ěśí ě§ěě ě¸ ě°ęľŹ ëł´ěě íľí´ 기쥴ě ěě¤í

ëł´ë¤ ëě ěąëĽě ě ę˛ ëŞ¨ë¸ě 꾏ěśíë ë°ě íěŠí ě ěě ę˛ě´ë¤.

ě ěë ěë°Šěě¤ ě ę˛ ěě¤í

ě íëĄë ěŚëĽź íľí´ 캥ě˛í ě´ëŻ¸ě§ëĽź ě

ë Ľ ë°ě´í°ëĄ ë°ě ěë˛ëĄ ě ëŹíěŹ íěľë ëĽëŹë 모ë¸ě íľí´ ě˛ëŚŹíęł ěě§ë§, ěě ěíí ě¤íě ë°íěźëĄ 모ë¸ě ěąëĽě ëě´ęł 경ëííë¤ëŠ´ on-device ííëĄë ěě¤í

ě íěŠí ě ěě ę˛ě´ë¤. ë ëěę° ě¤ěę°ěźëĄ ě ę˛ěě ěěšëĽź ě¸ěíęł , ě ę˛í ěě¤ëŹźě ěí뼟 ëĽëŹëě íľí´ íë¨í ě ěëëĄ íěľíë¤ëŠ´ ěśí ëŹ´ě¸ ě´ë체 ëąě íěŠí ëŹ´ě¸ ě ę˛ěźëĄë ë°ě í ę°ëĽěąë ěë¤. ě´ëĽź 기ë°ěźëĄ ěë°Šě ę˛ ěě¤í

ě ě°ęľŹ ëł´ěíë¤ëŠ´ ěë°Šěě¤ ę´ëŚŹěě ě

돴 í¨ě¨ ěŚě§ëżë§ ěëëź ěë°Šěě ěë ëěě ě¤ ě ěë ěě¤í

ěźëĄ ë°ě í ę˛ěźëĄ 기ëëë¤.

í 기

본 ě°ęľŹë 2023ë

ë ęłźí기ě ě ëł´íľě ëśě ěŹěěźëĄ ě ëł´íľě 기ííę°ěě ě§ě(2021-0-00751, 0.5 mm ę¸ ě´í ě´ě ë° ę°ěâ

ëšę°ě ě ëł´ íěśě ěí ë¤ě°¨ě ěę°í ëě§í¸ í¸ěíë ěěíŹ ę¸°ě ę°ë°) ë° íě ěě ëś ě§ëĽí ěíŠę´ëŚŹ 기ě ę°ë°ěŹě

ě ě°ęľŹëšě§ě(ęłźě ë˛í¸ 2021-MOIS37-001)ě ěí´ ěíëěěľëë¤.

References

2. J. H Bae, âProblems and Improvement Measures of the Self-Inspection System for Fire Facilitiesâ, National Assembly Resarch Service, (2018).

3. H. H Yu, K. B Bae and G. G Yang, âA Study on the Improvement Plan of the Self-inspection System of Fire-fighting Facilities:Focusing on Multi-family Housesâ, Korean Journal of Convergence Science, Vol. 9, No. 2, pp. 205-222 (2020),

https://doi.org/10.24826/KSCS.9.2.14.

4. K Muhammad, J Ahmad and S. W Baik, âEarly Fire Detection using Convolutional Neural Networks During Surveillance for Effective Disaster Managementâ, Neurocomputing, Vol. 228, pp. 30-42 (2018),

https://doi.org/10.1016/j.neucom.2017.04.083.

5. J Hu, X Gao, H Wu and S Gao, âDetection of Workers without the Helments in Videos based on YOLO V3â, International Congress on Image and Signal Processing, BioMedical Engineering and Informatics (CISP-BMEI), pp. 1-4 (2019),

https://doi.org/10.1109/CISP-BMEI48845.2019.8966045.

6. S Park, C Hong, S Park, J Lee and J Kim, âDevelopment of a Deep Learning-based Fire Extinguisher Object Detection Model in Underground Utility Tunnelsâ, Journal of the Society of Disaster Information, Vol. 18, No. 4, pp. 922-929 (2022),

https://doi.org/10.15683/kosdi.2022.12.31.922.

7. D. S Oh, K. B Lee and S. G Hong, âFirefighting Equipment Object Detection for Firefighting Inspection based on YOLOv4â, Proceedings of the Korean Information Science Society Conference, pp. 512-514 (2021).

8. J Redmon, S Divvala, R Girshick and A Farhadi, âYou Only Look Once:Unified, Real-time Object Detectionâ, In:Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pp. 779-788 (2016),

https://doi.org/10.48550/arXiv.1506.02640.

10. C. Y Wang, A Bochkovskiy and H. W. M Liao, âScaled- Yolov4:Scaling Cross Stage Partial Networkâ, In:Proceedings of the IEEE/cvf Conference on Computer Vision and Pattern Recognition, pp. 13029-13038 (2021),

https://doi.org/10.48550/arXiv.2011.08036.

11. D. S Oh, J. H Jeon, J. K Kim, K. B Lee and S. G Hong, âInspection System of Firefighting Facilities Based on YOLOv4 Using Augmented Reality Glassâ, International Conference on Information and Communication Technology Convergence (ICTC), pp. 1604-1608 (2022),

https://doi.org/10.1109/ICTC55196.2022.9952959.