1. D. E Kim, S. K Kim, Y. S Lee, C. H Lee and W. S Lim, “A Study on the Characteristics of an Optical Sensor Linear Fire Detection System with Miniature Model Fire Experiment”, Fire Science and Engineering, Vol. 30, No. 2, pp. 19-26 (2016),

https://doi.org/10.7731/KIFSE.2016.30.2.019.

2. B. K Seo and S. G Nam, “Study of the Improvement of False Fire Alarms in Analog Photoelectric Type Smoke Detectors”, Fire Science and Engineering, Vol. 30, No. 5, pp. 108-115 (2016),

https://doi.org/10.7731/KIFSE.2016.30.5.108.

3. Y. J Kim and E. G Kim, “Image based Fire Detection Using Convolution Neural Network”, Journal of the Korea Institute of Information and Communication Engineering, Vol. 20, No. 9, pp. 1649-1656 (2016),

https://doi.org/10.6109/jkiice.2016.20.9.1649.

4. S. W Jeong and J. H Yoo, “i-FireNet:A Lightweight CNN to Increase Generalization Performance for Real-Time Detection of Forest Fire in Edge AI Environments”, Journal of Institute of Control, Robotics and Systems, Vol. 26, No. 9, pp. 802-810 (2020),

https://doi.org/10.5302/J.ICROS.2020.20.0033.

5. S. H Ahn, Y. H Park and B. I Moon, “A Forest Fire Warning System Capable of Real-Time Detection based on Artificial Intelligence”, The Journal of Korean Institute of Information Technology, Vol. 21, No. 3, pp. 61-73 (2023),

https://doi.org/10.14801/jkiit.2023.21.3.61.

6. H Yar, Z. A Khan, F. U M. Ullah, W Ullah and S. W Baik, “A Modified YOLOv5 Architecture for Efficient Fire Detection in Smart Cities”, Expert Systems With Applications, Vol. 231, pp. 120465(2023),

https://doi.org/10.1016/j.eswa.2023.120465.

7. F. M Talaat and H ZainEldin, “An Improved Fire Detection Approach Based on YOLO-v8 for Smart Cities”, Neural Computing and Applications, Vol. 35, pp. 20939-20954 (2023),

https://doi.org/10.1007/s00521-023-08809-1.

8. N Dung, B. G Choi and S. H Ro, “A Study on the Fire Detection Algorithm Using Surveillance Camera Systems”, The Journal of Korea Institute of Communications and Information Sciences, Vol. 43, No. 6, pp. 921-929 (2016),

https://doi.org/10.7840/kics.2018.43.6.921.

9. J. K Ryu and D. K Kwak, “Flame Detection Based on Deep Learning Using HSV Color Model and Corner Detection Algorithm”, Fire Science and Engineering, Vol. 35, No. 2, pp. 108-114 (2021),

https://doi.org/10.7731/KIFSE.30befadd.

12. V Venugopal, “Image Processing Based Forest Fire Detection”, International Journal of Advanced Research in Engineering &Technology, Vol. 2, No. 2, pp. 87-95 (2012).

13. A Munshi, “Fire Detection Methods Based on Various Color Spaces and Gaussian Mixture Models”, Advances in Science and Technology Research Journal, Vol. 15, No. 3, pp. 197-214 (2021),

https://doi.org/10.12913/22998624/138924.

14. V. S Bochkov and L. Y Kataeva, “wUUNet:Advanced Fully Convolutional Neural Network for Multiclass Fire Segmentation”, Symmetry, Vol. 13, No. 1, pp. 98(2021),

https://doi.org/10.3390/sym13010098.

15. A Gonzalez, M. D Zuniga, C Nikulin, G Carvajal, D. G Cardenas, M. A Pedraza, R. I Munoz, C. A Fernandez and et al, “Accurate Fire Detection through Fully Convolutional Network”, 7

th Latin American Conference on Networked and Electronic Media, pp. 1-6 (2017),

https://doi.org/10.1049/ic.2017.0026.

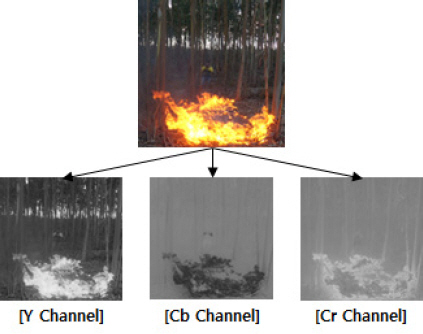

18. H. S Lee and W. H Kim, “The Flame Color Analysis of Color Models for Fire Detection”, The Journal of Korea Society of Communication and Space Technology, Vol. 8, No. 3, pp. 52-57 (2013),

https://www.earticle.net/Article/A209485.